| Разработчики: | Nvidia (Нвидиа) |

| Дата премьеры системы: | 2019 |

| Отрасли: | Электротехника и микроэлектроника |

| Технологии: | СХД, Серверные платформы, Суперкомпьютер, Центры обработки данных - технологии для ЦОД |

Содержание |

В современном мире инструменты работы с искусственным интеллектом и возможность масштабирования становятся обязательным требованием к ИТ-инфраструктуре любого предприятия. Вместе с тем, далеко не каждая компания обладает необходимой экспертизой для создания вычислительной инфраструктуры, которая будет сохранять актуальность долгие годы. Для компаний, которые заинтересованы в быстром развертывании гибких масштабируемых систем, готовых для ИИ, появилось удобное решение «из коробки» - Nvidia DGX POD. Это масштабируемая архитектура ЦОД для ИИ, разработанная на базе лучших мировых практик и собственного опыта "интеллектуальных" суперкомпьютеров Nvidia.

Nvidia DGX POD объединяет в единую сбалансированную систему одну или несколько стоек серверов семейства DGX, сетевое оборудование, устройства хранения данных, электропитания и охлаждения, а также программное обеспечение, обеспечивающее эффективное управление обработкой данных в процессе решения прикладных задач, в том числе связанных с ИИ.

В основе концепции DGX POD 2 технологические идеи. Во-первых, благодаря использованию графического ускорителя Tesla V100, сочетающего разные типы вычислительных ядер, классический сервер превращен в универсальный суперкомпьютер, обеспечивающий высокую производительность как в задачах HPC, так и в задачах ИИ. Причем этот «суперкомпьютер» производительностью в один Петафлопс (на задачах глубокого обучения) размещается всего в 10 серверных юнитах. Причем развернуть такую систему можно всего за несколько дней.

Вторая идея связана с избавлением от пропорциональной зависимости между производительностью `умных` приложений и требуемой мощностью (а также стоимостью, что немаловажно) аппаратной части «суперкомпьютера». В рамках архитектуры DGX POD постепенное наращивание «железных» ресурсов дает практически линейный прирост производительности ИИ-приложений на каждом шаге.

Один из ключевых элементов архитектуры графических ускорителей – тензорные ядра (Tensor Core). Они радикально ускоряют математические операции с большими матрицами, с помощью которых сегодня исполняются практически все нейросетевые алгоритмы. Так, вычисления с плавающей точкой при использовании ускорителя Tesla V100 выполняются приблизительно в 50 раз быстрее, чем на сервере на базе CPU.Гид TAdviser по российским заводам компьютерной техники

Посмотрим подробнее, как это реализовано на программном и аппаратном уровнях.

Полный программный стек для ИИ

Одним из важных преимуществ решений на базе архитектуры DGX POD является идущий в комплекте полный программный стек специализированного ПО и фреймворков для работы с алгоритмами ИИ и нейросетями. Речь идет как о собственных программных инструментах Nvidia, так и об оптимизированных сторонних библиотеках.

Один из ключевых компонентов - Nvidia DIGITS (Deep Learning GPU Training System). Это среда, помогающая пользователям настроить, сконфигурировать и обучить глубокую нейронную сеть, используя все возможности ускорения вычислительных процессов на базе GPU. Она включает в том числе cuDNN - библиотеку программирования на базе модели параллельного программирования CUDA. cuDNN на порядок ускоряет процессы глубокого обучения на GPU, по сравнению с CPU. Благодаря простоте использования, cuDNN позволяет разработчикам быстро создавать и оптимизировать новые модели и разрабатывать приложения более высокой точности, используя вычислительную мощь GPU-ускорителей.

Для ускоренного анализа Big Data и машинного обучения разработан набор инструментов RAPIDS.

Nvidia Data Loading Library (DALI) – библиотека, ориентированная на data-емкие приложения, требующие высокоинтенсивной вычислительной обработки, например, загрузка данных с диска, декодирование, преобразование форматов данных и т.п. DGX POD поддерживает все популярные у разработчиков фреймворки глубокого обучения: MXNet, TensorFlow, Theano, PyTorch, Caffe. Причем Nvidia не только поддерживает сторонние разработки, но и создает оптимизированные варианты фреймворков: Caffe, ONNX, WinML и др. В результате на процессорах Tesla обеспечивается почти линейное масштабирование обучения глубоких сетей с ускорением пропускной способности в десятки раз.

Программно-аппаратная платформа Nvidia ускоряет не только обучение нейронных сетей, но и процессы инференса, то есть работу обученной системы в реальных условиях. Так, в задачах распознавания и синтеза речи, машинного перевода, распознавания изображений, обеспечения функционирования автономных систем TensorRT способен ускорить инференс до 190 раз, по сравнению с CPU.

GPU-ускорение для инференса глубокого обучения дает возможность крупным нейросетям работать практически в режиме реального времени, не требуя увеличения затрат на аппаратную часть. По оценкам Nvidia, это обеспечивает высокую точность работы сетей с целочисленной математикой и данными с плавающей точкой, что, в свою очередь, позволяет сократить серверные затраты до 70%.

Все доступные библиотеки и прочие инструменты, предназначенные для создания и работы ИИ-приложений и высокопроизводительных вычислений объединяются в постоянно обновляемый комплект разработчика Deep Learning SDK, который обеспечивает оптимизацию производительности для приложений, использующих графические ускорители.

Готовые модели, которые также входят в комплект ПО для поддержки ИИ-задач (Nvidia AI), обучены с размеченными данными с помощью DL-платформы глубокого обучения.

Важным компонентом программной составляющей архитектуры является Nvidia GPU Cloud (NGC), облачная платформа с графическим ускорением, оптимизированная для глубокого обучения. Платформа ориентирована на тех разработчиков приложений, которые не хотят связываться с ручной настройкой и отладкой нейросетевых сред. Это ИТ-решение поставляется вместе с NGC Deep Learning Stack — средой разработки, которая способна работать на ПК, суперкомпьютерах DGX и в облаке.

Пользователь может начать работу с одного графического процессора на ПК, а потом добавить дополнительные вычислительные ресурсы с помощью DGX-системы или через облако. Можно импортировать данные, настраивать конфигурацию задания, выбирать фреймворк. А потом загрузить результат в TensorRT для вывода. Фактически с помощью NGC разработчики могут создавать модели любого размера или типа, используя универсальную платформу, а также увеличивать или уменьшать объем используемых вычислительных ресурсов в зависимости от текущих потребностей.

Системное ПО

Операционная система DGX OS создана на базе оптимизированной версии ОС Linux Ubuntu и специально адаптирована к аппаратным средствам DGX. DGX OS включает сертифицированные драйверы GPU, стек сетевого ПО, предварительно сконфигурированный кэш файловой системы NFS, инструменты диагностики и управления GPU дата-центра Nvidia (DCGM), а также фирменные комплекты ПО Nvidia: CUDA Toolkit, cuDNN, NCCL и другие библиотеки Nvidia, включая поддержку технологии GPUDirect и Docker Engine Utility для GPU Nvidia.

Ключевая архитектура стека программного обеспечения DGX POD – контейнеризированные микросервисы. Архитектура CaaS (Container as a Service) обеспечивает высокую масштабируемость, гибкость и безопасность работы системы.

В формат контейнеров «упакованы» все инструменты ускорения GPU, оптимизированные, протестированные и полностью готовые к запуску на поддерживаемых GPU Nvidia локальных и облачных системах. Фреймворки нейросетей и инструменты управления ими (TensorFlow, PyTorch, MXNet, TensorRT и др.) также оформлены в контейнеры и готовы к развертыванию и исполнению под управлением ПО контейнеризации Docker в любой поддерживаемой среде, где будут работать абсолютно одинаково.

Помимо контейнеров, оптимизированных для GPU-ускорения, которые составляют контейнерный реестр облака NGC, и операционной системы DGX OS, комплект системного программного обеспечения Nvidia AI включает инструменты управления кластерами Kubernetes, библиотеки Nvidia, планировщики рабочей нагрузки, а также полезное свободное ПО (open source), предварительно протестированное в Nvidia и снабженное рекомендациями по практическому использованию. Готовые модели также размещаются в репозитории контейнера NGC.

Программный слой управления POD DGX состоит из различных сервисов, работающих в среде управления Kubernetes с целью обеспечения отказоустойчивости и высокой доступности. Сервисы обеспечиваются для сетевой конфигурации (DHCP) и полностью автоматизированного развертывания ПО DGX OS по сети в соответствии с протоколом удаленной загрузки (PXE). За мониторинг приложений и серверов приложений отвечает Prometheus — популярный CNCF-проект с открытым исходных кодом, полностью совместимый с Docker, созданный в духе DevOps-культуры. Дополнительный плюс его применения заключается в том, что придется скачать всего один бинарный файл и запустить вместе с компонентами Prometheus. За обработку предупреждений отвечает Alertmanager, умеющий коммуницировать по различным каналам доставки сообщений, включая электронную почту.

Программное средство Grafana используется для визуализации и анализа данных, как внутренних, так и внешних проектов. Это платформа с открытым исходным кодом, дает возможность пользователям создавать дашборды с панелями, каждая из которых отображает определенные показатели в течение установленного периода времени.

В некоторых ситуациях, например, если нужно задействовать дополнительные сервисы на площадке пользователя, локальный реестр контейнеров может стать «зеркалом», как контейнеров NGC, так пакетов Ubuntu и Python, и вся эта конструкция будет запускаться на уровне управления Kubernetes, обеспечивая поддержку всех сервисов кластера.

Средства управления DGX POD обеспечивают также поддержку кластеров под управлением SLURM. Этот высокомасштабируемый отказоустойчивый менеджер кластеров и планировщик заданий, ориентированный на большие кластеры и вычислительные узлы, входит в число лидеров среди менеджеров ресурсов и используется на многих самых мощных суперкомпьютерах мира (изначально эту разработку вела группа компаний, в том числе, Ливерморская национальная лаборатория имени Э. Лоуренса).

Программное обеспечение DGX POD обеспечивает динамическое формирование разделов Kubernetes и SLURM таким образом, что ресурсы могут перемещаться между разделами, если это требуется текущей рабочей нагрузкой. Простой пользовательский интерфейс позволяет администраторам перемещать серверы DGX между Kubernetes-и SLURM-доменами. При этом Kubernetes обеспечивает высокий уровень гибкости при выравнивании нагрузки, обработке отказов узлов, а также резких всплесков данных в сторону внешних кластеров Kubernetes, включая инстансы публичного облака NGC. А SLURM поддерживает более статическую кластерную среду, но зато с дополнительной функциональностью управления в стиле высокопроизводительных вычислений.

Управление ПО Nvidia AI на DGX POD выполняется с помощью инструмента управления конфигурациями Ansible. Это популярная система, написанная на Python, с использованием декларативного языка разметки для описания конфигураций. Обычно используется для автоматизации настройки и развертывания ПО на Linux-узлах, но также поддерживает Windows.

Ключевое достоинство Ansible — не требуется установка агента/клиента на целевые системы. Для системы удаленного управления конфигурацией достаточно описать нужное состояние управляемого узла, а она сама определит, что нужно сделать для достижения этого состояния, и осуществит все необходимые действия. Иными словами, Ansible берет на себя всю работу по приведению удаленных серверов в необходимое состояние. Администратору необходимо лишь описать, как достичь этого состояния с помощью, так называемых сценариев. Такая технология позволяет очень быстро осуществлять переконфигурирование системы: достаточно всего лишь скорректировать несколько строк в сценарий.

Таким образом, в рамках архитектуры DGX POD для каждого пользователя обеспечивается доступ ко всему многообразию программного обеспечения, которое создает и поддерживает функционирование устойчивой высокопроизводительной вычислительной среды, адаптированной к самым выдающимся ресурсным потребностям глубокого обучения. В том числе: фреймворк глубокого обучения Nvidia DIGITS, контейнеры HPC, сторонние решения для GPU-ускорения, решения Nvidia SDK для глубокого обучения, библиотеки cuDNN, cuBLAS, NCCL, набор инструментов CUDA, библиотеки обработки Big Data RAPIDS и всем необходимым драйверам Nvidia.

Аппаратная часть архитектуры DGX POD

Программно-аппаратный комплекс DGX POD включает:

- одну или несколько стоек серверов семейства DGX;

- систему хранения данных;

- сетевое оборудование;

- облако Nvidia GPU Cloud (NGC) для поддержки глубокого обучения и ускоренных вычислений;

- серверы управления POD DGX и соответствующее ПО.

В целом POD DGX представляет собой оптимизированную стойку дата-центра, которая может содержать до девяти серверов DGX-1 или три сервера DGX-2, серверы хранения и сетевые коммутаторы. Все оборудование поддерживает обучение моделей на одном или нескольких узлах с последующим инференсом с использованием стека ПО глубокого обучения Nvidia AI. Предусмотрено три базовых варианта реализации:

- DGX-2 Server (35 кВт);

- DGX-1 Server (35 kW);

- DGX-1 Server (18 kW).

Архитектура DGX POD разработана для установки в стандартную стойку 42RU, и использует дополнительную служебную стойку для cерверов управления. Следует отметить, что эталонная архитектура разработана для использования высокоплотных стоек, чтобы обеспечить наиболее эффективное использование дорогостоящей площади дата-центра и упростить сетевые кабельные соединения. Когда активность использования GPU растет, средний уровень потребления электропитания в расчете на один сервер и на одну стойку также растет. Однако более старые дата-центры могут не суметь поддерживать требуемый уровень электропитания и охлаждения. В связи с этим рекомендуется использовать дизайн решения с выделением трех зон, в которых компоненты POD DGX будут установлены в трех стойках с низким энергопотреблением. Такой вариант приведен на фото модели POD DGX-1 (18 кВт).

Все серверы соединяются 10 Гбит/c коммутатором, который обеспечивает им доступ к дата-центру сети. Протестирована конфигурация с высокопроизводительным коммутатором Arista Networks с 40 портами 10 Гбит/c Ethernet и 4 каналами 40 Гбит/c Ethernet. Эти модульные коммутаторы относятся к новому поколению коммутационных фабрик, ориентированных на обработку огромных объемов данных с минимальными задержками. Они достигают пропускной способности в десятки миллиардов пакетов в секунду. Функционал виртуальных сетей (VLAN) помогает организовать обмен управляющей информацией независимо от передачи данных по сети при использовании одного и того же физического оборудования. Помимо Arista Networks, Nvidia работает с другими поставщиками сетевых решений, совместимых с требованиями архитектуры DGX POD.

36-портовый 100 Гбит/c коммутатор Mellanox поддерживает четыре 100 Гбит/c соединений InfiniBand в стойке DGX серверов. Такая структура обеспечивает наилучшую масштабируемость для конфигураций из многих узлов.

Таким образом, на базе серверов семейства DGX становится возможным объединить рабочие нагрузки приложений ИИ и высокопроизводительных вычислений в единую унифицированную архитектуру - DGX POD. Возможно также использовать несколько инсталляций DGX POD для запуска задач масштаба кластера. Тогда корневой коммутатор InfiniBand конфигурируется в служебной стойке в сочетании с вторым 36-портовым коммутатором Mellanox.

С точки зрения систем хранения данных, DGX POD использует иерархический дизайн с множественными уровнями кэширования памяти, включая твердотельные массивы DGX SSD и дополнительные сервера кэш-памяти. В базовой конфигурации система хранения DGX POD состоит из серверов хранения NFS, размещенных в стойке и используемых в сочетании с локальным кэшем DGX SSD. Устройства для долговременного хранения сырых данных могут быть размещены на самых разных носителях вне DGX POD, как на площадке компании, так и в публичном облаке.

Суперкомпьютер из коробки

В основе архитектуры DGX POD концепция «суперкомпьютера из коробки». Вычислительный комплекс DGX-1 изначально создавался как платформа для обучения глубоких нейронных сетей. Это готовое решение, которое содержит в себе все необходимые оптимизированные программные инструменты для работы с ИИ. Исследователи и специалисты по анализу данных сразу же могут начать им пользоваться для решения своих задач и получить первые результаты уже через несколько часов.

Максимальную производительность системы в задачах обучения нейросетей обеспечивает гибридная топологию «ячеистого гиперкуба» (или mesh-гиперкуба, cube-mesh) на восьми GPU Tesla V100, соединенных между собой по технологии NVLink.

Для решения больших задач традиционно применяются системные конфигурации на основе 4 и 8 GPU, которые соединены между собой интерфейсом PCIe. Однако пропускная способность PCIe все чаще становится слабым местом мульти-GPU систем, что стало стимулом к переходу на более быструю и масштабируемую технологию внутренних соединений.

NVLink компании Nvidia — это высокопроизводительная энергоэффективная компьютерная шина, которая позволяет организовать прямое взаимодействие точка-точка между несколькими GPU или GPU-CPU. Базовым элементом NVLink 2.0 является канал с пропускной способностью 25 Гб/с. Агрегирование до шести каналов NVLink 2.0 в ускорителе Tesla V100 обеспечивает пропускную способность трафика до 150 Гб/с (300 Гб/с с учетом дуплекса), что в 10 раз превосходит показатели PCIe третьего поколения.

Один из ключевых элементов архитектуры графических ускорителей – специализированные тензорные ядра (Tensor Core). Они радикально ускоряют математические операции с большими матрицами, с помощью которых исполняются практически все нейросетевые алгоритмы. В частности, тензорные ядра позволяют осуществлять умножение матриц со смешанной точностью и сводить вычисления в одну операцию. Благодаря одновременной работе сотен таких тензорных ядер, функционирующих параллельно в одном GPU Nvidia, производительность и энергоэффективность системы значительно повышаются.

Так, каждое из 640 тензорных ядер ускорителя Tesla V100 может обрабатывать матрицу 4x4 и выполнять 64 операции со смешанной точностью за такт. Это обеспечивает производительность в 125 Терафлопс в задачах тренировки алгоритмов и инференса, где используются вычисления смешанной точности (FP16 и FP32). В целом, вычисления с плавающей точкой при использовании ускорителя Tesla V100 выполняются приблизительно в 50 раз быстрее, чем на сервере на базе CPU.

Кроме того, ускоритель Tesla V100 содержит 80 многопроцессорных систем потоковой передачи данных (потоковых мультипроцессоров, SMX), реализованных максимально экономично. Высокий уровень экономичности SMX был достигнут за счет увеличения количества ядер CUDA при сокращении частоты каждого ядра, отключения питания частей GPU, находящихся в простое, и увеличения площади GPU, предназначенной для ядер для параллельных расчетов, вместо управляющей логики.

Таким образом, графический ускоритель Tesla V100 является универсальным решением как для высокопроизводительных вычислений (HPC), так и для ИИ-систем. Он показывает отличные результаты, как в задачах моделирования сложных объектов, так и при анализе данных большого объема. Благодаря объединению в одной архитектуре ядер CUDA и тензорных ядер, сервер, оснащенный графическими ускорителями Tesla V100, может заменить сотни традиционных CPU-серверов, выполняя и традиционные задачи HPC, и приложения искусственного интеллекта. Причем, этот «суперкомпьютер» производительностью в один Петафлопс (на задачах глубокого обучения) размещается всего на 10 серверных стойках.

Результаты получены для нейронной сети с остаточным обучением ResNet-50 (90 эпох)

А для поддержки обработки Big Data обеспечивается эффективная широкополосная передача обучающих данных и отказоустойчивая система хранения. В базовой конфигурации СХД поставляется с 480 Гб диском SSD (на нем размещается загрузочная область ОС) и четырьмя 1,92 Tб дисками SAS/SSD общей емкостью 7,6 Тб, сконфигурированных в виде массива RAID 0, то есть дискового массива повышенной производительности с чередованием. Это означает, что данные равномерно распределяются по дискам массива. При этом распределенные операции чтения и записи позволяют значительно увеличить скорость работы, поскольку несколько дисков одновременно читают/записывают свою порцию данных.

Плюс данной технологии хранения заключается в том, что пользователю доступен весь объем дисков, однако это снижает надежность хранения данных. Но четыре диска SSD/SAS вместе обеспечивают совокупную пропускную способность потокового чтения 2 Г/с, которая достаточна для предотвращения дисковых узких мест потоковой передачи во время обучения.

Как решение для ИИ, система DGX-1 использует все достоинства сетевой топологии «ячеистого гиперкуба», которые позволяют оптимизировать множество факторов: от полосы пропускания для множества соединений точка – точка и примитивов коллективных коммуникаций до способности поддерживать множество общих коммуникационных паттернов (профилей) и обеспечивать производительность в ситуации, когда задействовано некоторое подмножество GPU. Все эти особенности определяют развитые способности DGX-1 к эффективному масштабированию при решении сложных прикладных задач типа глубокого обучения, быстрого преобразования Фурье, молекулярной динамики, анализа графов, вычислительной гидроаэродинамики, обработки сейсмических изображений, трассировки лучей в компьютерной графике и анимации.

Практика применения DGX POD

Выражение «прикладной суперкомпьютер» в отношении к DGX POD можно применять без кавычек. Так же, как и тезис о его «коробочном» формате. Действительно, архитектура DGX POD предполагает, что клиенту поставляется полностью готовое к работе программно-аппаратное решение с оптимизированным программным стеком, обеспечивающим доступ к фреймворкам глубокого обучения Nvidia и сторонних разработчиков. Фактически исследователь может развернуть систему, приступить к работе и получить первые результаты уже через несколько часов.

В классических высокопроизводительных вычислениях архитектура DGX POD также показывает очень хорошие результаты. Именно на базе этой архитектуры построены собственные вычислительные центры Nvidia. Первый из них - SATURNV с 660 узлами, использующий 5280 графических ускорителей V100, - продемонстрировал производительность 660 Петафлопс (на задачах глубокого обучения). Он оказался «самым зеленым», то есть энергоэффективным суперкомпьютером в мире с показателем 15 Гигафлопс/Вт в операциях с двойной точностью.

Еще один отличный пример быстрого развертывания суперкомпьютерной системы – проект Circe, реализованный на базе DGX-2H, расширенной версии сервера DGX-2 с 16 Tesla V100 GPU и новой технологий внутренней коммутации NVSwitch, что обеспечивает пропускную способность 2,1 Петафлопс. Суперкомпьютер Circe из 36 серверов Nvidia DGX-2H с 576 ускорителями Tesla V100, снабженных тензорными ядрами, был создан всего за три недели. За этот срок он еще умудрился установить шесть мировых рекордов в тестах MLPerf и ворвался в верхнюю часть списка Top500 самых мощных суперкомпьютеров мира. С показателем производительности свыше 3 Петафлопс Nvidia DGX-2H занял 61-ю строчку в мировом рейтинге.

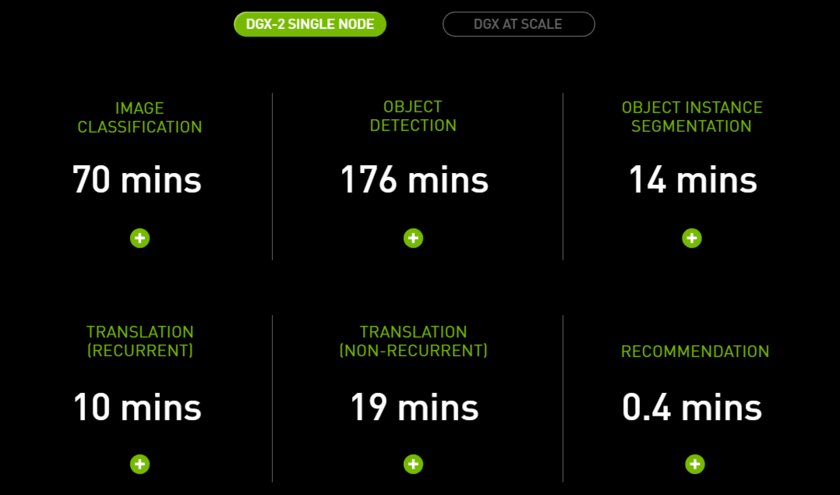

* Перевод: Классификация изображений | Выявление объекта | Сегментация объектов | Перевод с помощью рекуррентной нейросети | Перевод без рекуррентной нейросети | Генерация рекомендаций

И вот совсем свежие новости – на базе эталонной архитектуры DGX POD, точнее, ее версии DGX SuperPOD, вновь за три недели создана еще более совершенная суперкомпьютерная система DGX SuperPOD. Это решение большой плотности, которое включает 96 систем Nvidia DGX-2H с 1536 GPU, объединенных с помощью NVSwitch и сетевых решений Mellanox. С производительностью 9,4 Петафлопс DGX SuperPOD занял 22 позицию в июньском рейтинге Top500 суперкомпьютеров мира. Для обучения модели ResNet-50 он требует менее двух минут. Почувствуйте изменения, которые произошли всего за четыре года!

В 2015 г., когда эта модель машинного обучения появилась на рынке, тогдашней системе на одном графическом процессоре Nvidia K80 потребовалось для обучения 25 дней. При этом DGX SuperPOD занимает пространство, примерно в 400 раз меньшее, чем его соседи по рейтингу Top-500, достигшие подобного уровня производительности вычислений на тысячах серверов.

На базе эталонной архитектуры Nvidia DGX POD можно реализовать решения на базе систем хранения данных Dell EMC (решение Dell EMC Isilon с Nvidia DGX-1), IBM (Spectrum Storage for AI с Nvidia DGX-1), NetApp (NetApp ONTAP AI на базе Nvidia DGX и дисковых all-flash массивов NetApp), Pure Storage (готовая для задач ИИ архитектура хранения AIRI) и сетевых продуктов Arista Networks, Cisco, DDN, Mellanox и др. глобальных технологических партнеров Nvidia. Сертифицированный набор компонентов позволяет быстро и экономично построить свой «корпоративный суперкомпьютер», то есть современный data-центр, способный поддерживать самые высоконагруженные задачи бизнес-аналитики и глубокого обучения, необходимые для ее успешной деятельности. Так, кстати, уже поступили не только Facebook и Microsoft, но и такие отраслевые лидеры, как BMW, Continental, Ford и Zenuity.

Для максимально оперативного создания корпоративного супер-ЦОДа Nvidia разработала ряд отраслевых вариантов эталонной архитектуры DGX POD, учитывающих специфику задач, решаемых в каждой отрасли: обработка медицинских изображений, ИТ-системы для нефтегазовой отрасли, системы компьютерного зрения для беспилотного автотранспорта и обучение автономных автомобильных систем, ИТ-обеспечение академических исследований и образовательных структур.